PDF转Excel爬虫:从数据泥潭中解放你的双手

PDF转Excel爬虫:从数据泥潭中解放你的双手

引言:当PDF报表成为数据分析的拦路虎

不知道你有没有遇到过这种情况:财务部门发来一份上百页的PDF报表,里面密密麻麻全是表格数据,老板让你今天下班前完成数据分析。你看着这些“只可远观不可亵玩”的数据,内心是不是崩溃的?我曾经就为了处理一份银行流水PDF,手动复制粘贴了整整一个下午,眼睛都快看瞎了。正是这种痛苦的经历,让我开始研究**pdf转excel爬虫**技术,今天就把这些年的实战经验分享给大家。

什么是PDF转Excel爬虫?

传统转换工具的局限性

很多人第一反应是用Adobe Acrobat或者在线转换工具,但这些工具往往存在几个致命问题:- 格式错乱,表格结构完全被打乱

- 无法处理复杂排版或扫描版PDF

- 批量处理需要付费,成本高昂

- 数据准确性无法保证

爬虫思维带来的革命

真正的**pdf转excel爬虫**解决方案,其实是模拟人工读取数据的逻辑,但用程序自动化实现。它不仅仅是格式转换,更是一种智能的数据提取技术。举个例子,上周我帮一个做市场研究的朋友处理竞品价格PDF,用传统的转换工具完全失效,但通过定制化的**pdf转excel爬虫**程序,不仅准确提取了数据,还自动进行了价格趋势分析。

实战:三种PDF转Excel爬虫方案对比

方案一:Python + Tabula-py(适合技术型选手)

如果你有一定的编程基础,这是我首推的方案。在**window**系统下配置Python环境非常简单:- 安装Python 3.8+版本

- 通过pip安装tabula-py库:

pip install tabula-py - 安装Java运行环境(Tabula基于Java)

核心代码示例:

```pythonimport tabulaimport pandas as pd# 读取PDF中的表格tables = tabula.read_pdf("input.pdf", pages='all')# 将提取的数据保存为Excelwith pd.ExcelWriter('output.xlsx') as writer:for i, table in enumerate(tables):table.to_excel(writer, sheet_name=f'Sheet_{i+1}')```适用场景:结构化程度高的表格,比如财务报表、数据报表等。优势:免费、可定制化程度高、批量处理能力强。

方案二:Power Automate(适合Office重度用户)

如果你主要使用Office套件,特别是已经在使用**window** 10或11系统,那么Power Automate是个隐藏的宝藏。我最近在帮一个行政同事优化考勤流程,她们每月要处理几百份PDF考勤表。通过Power Automate,我们实现了:

- 自动从邮箱获取PDF附件

- 调用AI模型识别表格区域

- 将数据写入统一的Excel模板

- 自动发送处理结果邮件

操作步骤:

- 在**window**搜索栏输入“Power Automate”并打开

- 选择“桌面流”创建新流程

- 使用“提取PDF数据”动作,设置数据提取规则

- 添加Excel操作,将数据写入指定位置

方案三:专业PDF爬虫工具(适合业务人员)

对于非技术人员,我推荐使用像Parseur、DocParser这样的专业工具。虽然需要付费,但学习成本极低。上周一个做供应链管理的朋友告诉我,他用Parseur处理供应商报价单,原本需要2天的工作现在10分钟搞定。这种基于**pdf转excel爬虫**原理的工具,特别适合固定格式的文档处理。

避坑指南:PDF转Excel爬虫常见问题解决

问题一:表格线不清晰导致识别失败

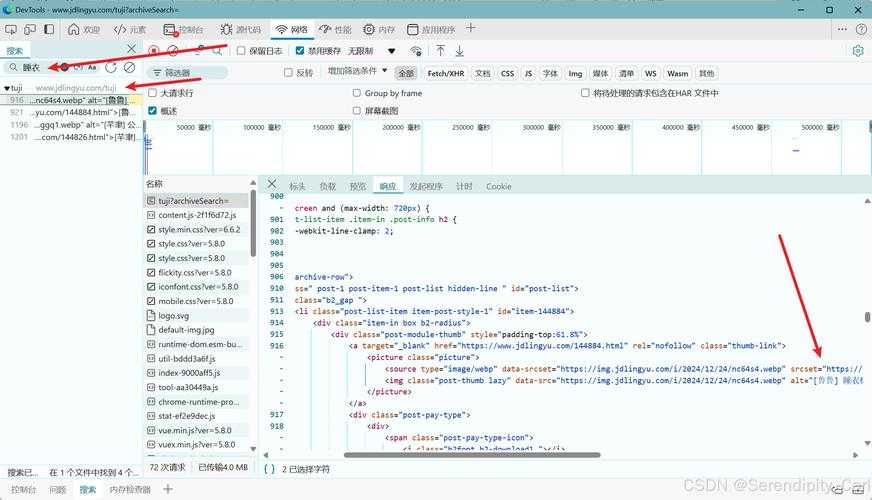

解决方案:先用PDF编辑器增强表格线,或者使用OCR技术先识别文本再重构表格。我常用的技巧是在**window**下用Adobe Acrobat的“增强扫描”功能,将PDF优化后再进行处理。

问题二:跨页表格被分割

这是最让人头疼的问题之一。我的经验是:- 在**pdf转excel爬虫**脚本中添加页面连续性检测

- 通过表头重复出现的位置判断表格边界

- 使用Python的PyPDF2库分析页面布局

问题三:特殊字符和格式丢失

特别是货币符号、百分比等关键信息,一旦丢失数据分析就毫无意义。建议:- 先提取原始文本保留所有字符

- 建立映射规则处理特殊格式

- 在**window** PowerShell中编写预处理脚本

进阶技巧:让PDF爬虫更智能

基于机器学习的智能识别

最近我在研究使用Google的Vision API或者Azure Form Recognizer,这些服务能够:- 自动学习表格结构模式

- 处理手写体和非标准格式

- 识别关键字段并分类

自动化工作流设计

真正的效率提升来自于端到端的自动化。在我的**window**工作环境中,我设置了这样的流程:- 监控指定文件夹的新增PDF

- 自动调用Python爬虫脚本

- 将结果写入共享Excel文件

- 通过Teams自动通知相关人员

实际应用场景分析

财务数据处理

银行对账单、发票、报销单...财务领域是**pdf转excel爬虫**技术应用最广泛的场景。通过自动化处理,我们团队现在每月能节省至少40小时的手工操作时间。市场研究报告分析

券商研报、行业分析等PDF文档包含大量表格数据,用爬虫技术可以快速建立竞争对手数据库。学术研究数据收集

科研人员经常需要从学术论文的PDF中提取实验数据,**pdf转excel爬虫**技术大大加快了研究进度。总结:选择适合你的PDF转Excel爬虫方案

经过多年的实践,我认为没有“最好”的方案,只有“最合适”的方案:- 技术爱好者:选择Python方案,灵活性强

- Office重度用户:Power Automate无缝集成

- 业务人员:专业工具省时省力

最后给大家一个小建议:在**window**系统下进行PDF处理时,尽量保持系统更新到最新版本,很多新特性都能提升处理效率。如果你在实践过程中遇到任何问题,欢迎在评论区交流,我很乐意分享更多实战经验!

你可能想看: